Soutenance de thèse, Mercedes García Martínez

Date : 27/03/2017

Heure : 14h00

Lieu : amphithéâtre, bâtiment IC2, LIUM, Université du Mans

Titre : Traduction Automatique Neuronale Factorisée

Composition du jury :

Rapporteurs :

– Marcello FEDERICO, Professeur, Fondazione Bruno Kessler, Trento

– Alexandre ALLAUZEN, Maître de conférence HDR, LIMSI-CNRS, Université Paris-Sud

Examinateurs :

– Lucia SPECIA, Professeur, University of Sheffield

– Francisco CASACUBERTA, Professeur, Universitat Politècnica de València

Directeur de Thèse : Yannick ESTÈVE, Professeur, LIUM, Le Mans Université

Co-directeur de Thèse : Loïc BARRAULT, Maître de conférence, LIUM, Le Mans Université

Co-encadrant de Thèse : Fethi BOUGARES, Maître de conférence, LIUM, Le Mans Université

Résumé :

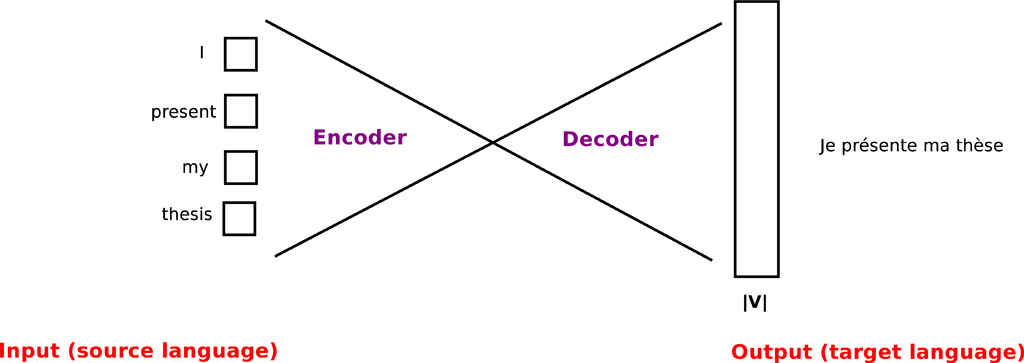

La diversité des langues complexifie la tâche de communication entre les humains à travers les différentes cultures. La traduction automatique est un moyen rapide et peu coûteux pour simplifier la communication interculturelle. Récemment, la Traduction Automatique Neuronale (NMT) a atteint des résultats impressionnants.

Cette thèse s’intéresse à la Traduction Automatique Neuronale Factorisé (FNMT) qui repose sur l’idée d’utiliser la morphologie et la décomposition grammaticale des mots (lemmes et facteurs linguistiques) dans la langue cible. Cette architecture aborde deux défis bien connus auxquelles les systèmes NMT font face.

Premièrement, la limitation de la taille du vocabulaire cible, conséquence de la fonction softmax, qui nécessite un calcul coûteux à la couche de sortie du réseau neuronale, conduisant à un taux élevée mots inconnus. Deuxièmement, le manque de données adéquates lorsque nous sommes confrontés à un domaine spécifique ou une langue morphologiquement riche. Avec l’architecture FNMT, toutes les inflexions des mots sont prises en compte et un vocabulaire plus grand est modélisé tout en gardant un coût de calcul similaire. De plus, de nouveaux mots non rencontrés dans les données d’entraînement peuvent être générés. Dans ce travail, j’ai développé différentes architectures FNMT en utilisant diverses dépendances entre les lemmes et les facteurs.

En outre, j’ai amélioré la représentation de la langue source avec des facteurs. Le modèle FNMT est évalué sur différentes langues dont les plus riches morphologiquement. Les modèles à l’état de l’art, dont certains utilisant le Byte Pair Encoding (BPE) sont comparés avec le modèle FNMT en utilisant des données d’entraînement de petite et de grande taille. Nous avons constaté que les modèles utilisant les facteurs sont plus robustes aux conditions d’entraînement avec des faibles ressources. Le FNMT a été combiné avec des unités BPE permettant une amélioration par rapport au modèle FNMT entrainer avec des données volumineuses. Nous avons expérimenté avec différents domaines et nous avons montré des améliorations en utilisant les modèles FNMT. De plus, la justesse de la morphologie est mesurée à l’aide d’un ensemble de tests spéciaux montrant l’avantage de modéliser explicitement la morphologie de la cible. Notre travail montre les bienfaits de l’application de facteurs linguistiques dans le NMT.

Mots-clés :

Traduction Automatique Neuronale, Modèles Factorisés, Apprendissage Profond, Réseaux de Neurones, Traduction Automatique

English

English