Multilingual speech translation under resource constraints

Encadrant(e)s: Antoine Laurent

Encadrant(e)s: Antoine Laurent

Equipe d’accueil : LIUM – LST

Lieu : Le Mans

Début de la thèse : dès que possible

Contact : Antoine.Laurent(at)univ-lemans.fr

Contexte : Ce post-doc est dans le domaine du traitement automatique du langage naturel (TALN) et plus particulièrement de la traduction automatique de la parole sous contraintes de ressources. Il fait partie du projet DGA Rapid COMMUTE.

Objectifs :Le chercheur postdoctoral sera chargé de mener des recherches compétitives dans le domaine de la traduction de la parole.

L’apprentissage de représentation auto-supervisé (SSRL) à partir de la parole [Harwath et al., 2016, Hsu et al., 2017, Khurana et al., 2019, Pascual et al., 2019, Schneider et al., 2019, Baevski et al., 2020a, Chung and Glass, 2020, Khurana et al., 2020, Baevski et al., 2020b, Harwath et al., 2020, Conneau et al., 2020, Liu et al., 2021b, Hsu et al., 2021, Chung et al., 2021, Babu et al., 2021, Liu et al., 2021a, Khurana et al., 2022, Bapna et al., 2022] s’est considérablement amélioré au cours des dernières années grâce à l’introduction du codage prédictif contrastif (CPC) [Oord et al., 2018], une méthode d’apprentissage de représentation auto-supervisée appliquée à la parole, au texte et aux données visuelles. L’introduction de l’idée centrale de l’estimation contrastive du bruit [Gutmann et Hyvärinen, 2010] dans le CPC a conduit à une série d’articles dans le domaine du SSRL de la parole, tels que Wav2Vec [Schneider et al, 2019], VQ-Wav2Vec [Baevski et al., 2020a], Wav2Vec-2.0 [Baevski et al., 2020b], Wav2Vec-2.0 multilingue [Conneau et al., 2020], XLS-R (XLS-R, une version plus grande du wav2vec-2.0 multilingue) [Babu et al., 2021]. Les codeurs vocaux SSRL pré-entraînés comme XLS-R sont considérés comme des “modèles de base” [Bommasani et et. al., 2021] pour les applications de traitement de la parole multilingue en aval, telles que la reconnaissance automatique de la parole multilingue [Conneau et al, 2020, Rivière et al., 2020, Babu et al., 2021], la traduction multilingue de la parole [Li et al., 2020, Babu et al., 2021, Bapna et al., 2022] et d’autres tâches de prédiction des propriétés para-linguistiques [Shor et al., 2021, wen Yang et al., 2021]. Ce travail se concentre sur la traduction multilingue de la parole.

L’architecture de réseau neuronal standard utilisée pour la TMS est le modèle codeur-décodeur [Sutskever et al., 2014, Vaswani et al., 2017]. Récemment, la TMS a connu des améliorations significatives grâce à : (i) une meilleure initialisation de l’encodeur et du décodeur du modèle de traduction avec des encodeurs de parole pré-entraînés, comme XLS-R [Babu et al., 2021], et des décodeurs de texte, comme MBART [Liu et al., 2020], (ii) de meilleures stratégies de réglage fin [Li et al., 2020], et (iii) des corpus parallèles de traduction parole-texte [Iranzo-Sánchez et al., 2019, Wang et al., 2020].

Cependant, les performances sur les tâches à faibles ressources restent médiocres et, en particulier, l’écart de performance (écart de transfert interlinguistique) entre les langues à ressources élevées et les langues à faibles ressources reste important. Nous émettons l’hypothèse que cela est dû au fait que le codeur vocal XLS-R apprend des caractéristiques non robustes au niveau de la surface à partir de données vocales non étiquetées, plutôt que des connaissances linguistiques de haut niveau sur la sémantique.

Pour injecter des connaissances sémantiques dans les représentations XLS-R apprises, nous nous tournons vers le cadre d’apprentissage de représentation multilingue multimodale alignée sémantiquement, SAMU-XLS-R [Khurana et al., 2022], récemment introduit. SAMU-XLS-R est un cadre de distillation de connaissances qui distille des connaissances sémantiques à partir d’un modèle d’intégration de texte pré-entraîné dans le codeur vocal XLS-R multilingue pré-entraîné.

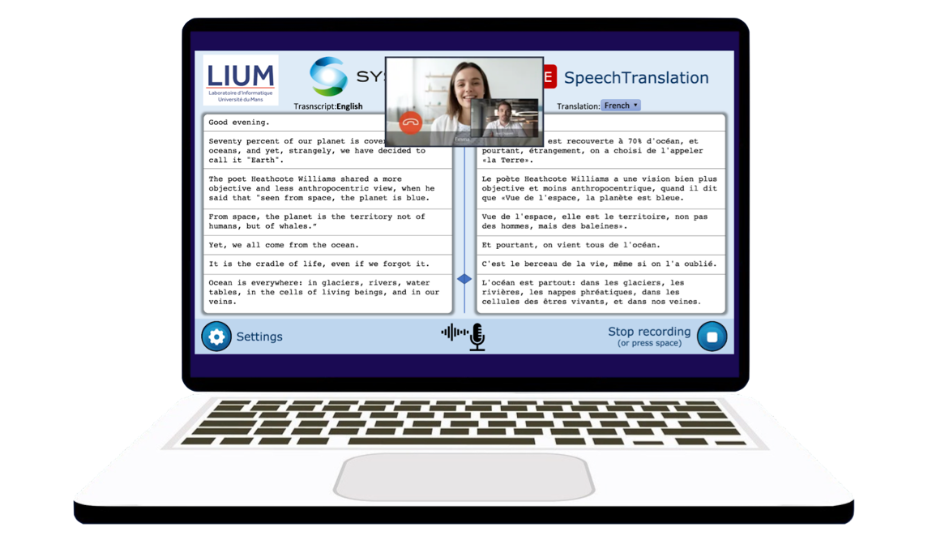

L’objectif de ce travail est d’améliorer ce cadre et de proposer un nouveau modèle qui permette de traiter l’audio en continu. Les résultats de ce travail seront intégrés dans un démonstrateur.

Organisation :Le travail sera effectué au LIUM. Le post-doctorant aura accès aux serveurs du laboratoire pour mener à bien ses recherches. Le salaire sera d’environ 42 000 euros bruts par an, pour une période d’un an, renouvelable une fois.

Candidature:

Envoyer CV et lettre de motivation à Antoine Laurent avant le 31 octobre, 18h (Antoine.Laurent(at)univ-lemans.fr)

Références :

- [Babu et al., 2021] Babu, A., Wang, C., Tjandra, A., Lakhotia, K., Xu, Q., Goyal, N., Singh, K., von Platen, P., Saraf, Y., Pino, J., Baevski, A., Conneau, A., and Auli, M. (2021). Xls-r: Self-supervised cross-lingual speech representation learning at scale. arXiv:2111.09296.

- [Baevski et al., 2020a] Baevski, A., Schneider, S., and Auli, M. (2020a). vq-wav2vec: Self-supervised learn- ing of discrete speech representations. In International Conference on Learning Representations.

- [Baevski et al., 2020b] Baevski, A., Zhou, H., Mohamed, A., and Auli, M. (2020b). wav2vec 2.0: A frame- work for self-supervised learning of speech representations. arXiv:2006.11477.

- [Bapna et al., 2022] Bapna, A., Cherry, C., Zhang, Y., Jia, Y., Johnson, M., Cheng, Y., Khanuja, S., Riesa, J., and Conneau, A. (2022). mSLAM: Massively multilingual joint pre-training for speech and text. arXiv:2202.01374.

- [Bommasani and et. al., 2021] Bommasani, R. and et. al. (2021). On the opportunities and risks of foundation models. arXiv:2108.07258.

- [Chung and Glass, 2020] Chung, Y.-A. and Glass, J. (2020). Generative pre-training for speech with autore- gressive predictive coding. In ICASSP 2020-2020 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 3497–3501. IEEE.

- [Chung et al., 2021] Chung, Y.-A., Zhang, Y., Han, W., Chiu, C.-C., Qin, J., Pang, R., and Wu, Y. (2021). W2v-bert: Combining contrastive learning and masked language modeling for self-supervised speech pre- training. arXiv:2108.06209.

- [Conneau et al., 2020] Conneau, A., Baevski, A., Collobert, R., Mohamed, A., and Auli, M. (2020). Unsuper- vised cross-lingual representation learning for speech recognition. arXiv:2006.13979.

- [Gutmann and Hyvärinen, 2010] Gutmann, M. and Hyvärinen, A. (2010). Noise-contrastive estimation: A new estimation principle for unnormalized statistical models. In Teh, Y. W. and Titterington, M., editors, Proceedings of the Thirteenth International Conference on Artificial Intelligence and Statistics, volume 9 of Proceedings of Machine Learning Research, pages 297–304, Chia Laguna Resort, Sardinia, Italy. PMLR

- [Harwath et al., 2020] Harwath, D., Hsu, W.-N., and Glass, J. (2020). Learning hierarchical discrete linguistic units from visually-grounded speech. In International Conference on Learning Representations.

- [Harwath et al., 2016] Harwath, D., Torralba, A., and Glass, J. (2016). Unsupervised learning of spoken language with visual context. Advances in Neural Information Processing Systems, 29.

- [Hsu et al., 2021] Hsu, W.-N., Bolte, B., Tsai, Y.-H. H., Lakhotia, K., Salakhutdinov, R., and Mohamed, A. (2021). Hubert: Self-supervised speech representation learning by masked prediction of hidden units. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 29:3451–3460.

- [Hsu et al., 2017] Hsu, W.-N., Zhang, Y., and Glass, J. (2017). Unsupervised learning of disentangled and interpretable representations from sequential data. Advances in neural information processing systems, 30.

- [Iranzo-Sánchez et al., 2019] Iranzo-Sánchez, J., Silvestre-Cerdà, J. A., Jorge, J., Roselló, N., Giménez, A., Sanchis, A., Civera, J., and Juan, A. (2019). Europarl-st: A multilingual corpus for speech translation of parliamentary debates. arXiv:1911.03167.

- [Khuranaetal.,2019] Khurana,S.,Joty,S.R.,Ali,A.,andGlass,J.(2019).Afactorialdeepmarkovmodelfor unsupervised disentangled representation learning from speech. In ICASSP 2019 – 2019 IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), pages 6540–6544.

- [Khurana et al., 2022] Khurana, S., Laurent, A., and Glass, J. (2022). Samu-xlsr: Semantically-aligned mul- timodal utterance-level cross-lingual speech representation. IEEE Journal of Selected Topics in Signal Processing, pages 1–13.

- [Khurana et al., 2020] Khurana, S., Laurent, A., Hsu, W.-N., Chorowski, J., Lancucki, A., Marxer, R., and Glass, J. (2020). A convolutional deep markov model for unsupervised speech representation learning. arXiv:2006.02547.

- [Lietal.,2020] Li,X.,Wang,C.,Tang,Y.,Tran,C.,Tang,Y.,Pino,J.,Baevski,A.,Conneau,A.,andAuli,M. (2020). Multilingual speech translation with efficient finetuning of pretrained models. arXiv:2010.12829.

- [Liu et al., 2021a] Liu, A. H., Jin, S., Lai, C.-I. J., Rouditchenko, A., Oliva, A., and Glass, J. (2021a). Cross- modal discrete representation learning. arXiv:2106.05438.

- [Liu et al., 2021b] Liu, A. T., Li, S.-W., and yi Lee, H. (2021b). TERA: Self-supervised learning of trans- former encoder representation for speech. IEEE/ACM Transactions on Audio, Speech, and Language Pro- cessing, 29:2351–2366.

- [Liu et al., 2020] Liu, Y., Gu, J., Goyal, N., Li, X., Edunov, S., Ghazvininejad, M., Lewis, M., and Zettle- moyer, L. (2020). Multilingual denoising pre-training for neural machine translation. Transactions of the Association for Computational Linguistics, 8:726–742.

- [Oord et al., 2018] Oord, A. v. d., Li, Y., and Vinyals, O. (2018). Representation learning with contrastive predictive coding. arXiv:1807.03748.

- [Pascual et al., 2019] Pascual, S., Ravanelli, M., Serrà, J., Bonafonte, A., and Bengio, Y. (2019). Learning problem-agnostic speech representations from multiple self-supervised tasks. arXiv:1904.03416.

- [Rivière et al., 2020] Rivière, M., Joulin, A., Mazaré, P.-E., and Dupoux, E. (2020). Unsupervised pretraining transfers well across languages. arXiv:2002.02848.

- [Schneider et al., 2019] Schneider, S., Baevski, A., Collobert, R., and Auli, M. (2019). wav2vec: Unsuper- vised pre-training for speech recognition. arXiv:1904.05862.

- [Shor et al., 2021] Shor, J., Jansen, A., Han, W., Park, D., and Zhang, Y. (2021). Universal paralinguistic speech representations using self-supervised conformers. arXiv:2110.04621.

- [Sutskever et al., 2014] Sutskever, I., Vinyals, O., and Le, Q. V. (2014). Sequence to sequence learning with neural networks. arXiv:1409.3215.

- [Vaswani et al., 2017] Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, L., and Polosukhin, I. (2017). Attention is all you need. arXiv:1706.03762.

- [Wang et al., 2020] Wang, C., Pino, J., Wu, A., and Gu, J. (2020). Covost: A diverse multilingual speech-to- text translation corpus. arXiv:2002.01320.

- [wen Yang et al., 2021] wen Yang, S., Chi, P.-H., Chuang, Y.-S., Lai, C.-I. J., Lakhotia, K., Lin, Y. Y., Liu, A. T., Shi, J., Chang, X., Lin, G.-T., Huang, T.-H., Tseng, W.-C., tik Lee, K., Liu, D.-R., Huang, Z., Dong, S., Li, S.-W., Watanabe, S., Mohamed, A., and yi Lee, H. (2021). Superb: Speech processing universal performance benchmark. arXiv:2105.01051.

English

English